北京赛车炸金花博彩平台博弈_使用Python分析网易云歌曲挑剔信息,通过可视化处分我发现了这些敬爱敬爱的规章

太平洋在线色碟

太平洋在线色碟

环球好,我是Python进阶者。

绪论前几天有个学生娃子找我帮衬作念点可视化的功课,功课本体包括相聚网易云音乐热评挑剔本体,数据量1W功课满盈,然后即是作念点数据分析有关的责任即可。这份大功课里边有汇集爬虫,少见据分析和数据处分,还有可视化,算是一个大现实了,还需要上交现实论述。这里拿出来部分常识点,给环球共享。学生娃的功课,参考了这个著述:网易云音乐挑剔爬取。

皇冠体育hg86a

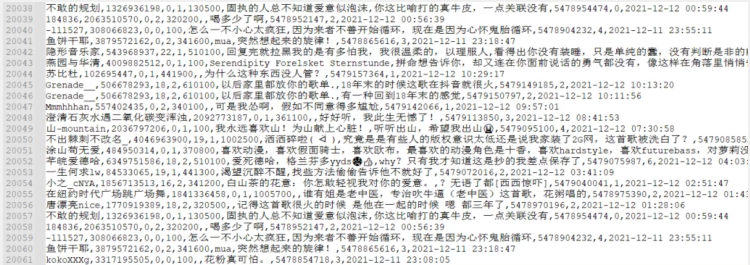

数据开头领先是数据开头,来自网易云音乐热评,代码这里就不放出来了,调用了API获得的,握取难度就少了很多,这里不在赘述了。

底下的代码主如果挑剔本领散播,主如果针对本领列作念了数据处分,老例操作,你也对照的去以日历和月份去挖掘下故敬爱的事情。

import 太平洋在线色碟pandas as pd from pyecharts import Line # 读取数据 df = pd.read_csv('music_comments.csv', header=None, names=['name', 'userid', 'age', 'gender', 'city', 'text', 'comment', 'commentid', 'praise', 'date'], encoding='utf-8-sig') # 凭证挑剔ID去重 df = df.drop_duplicates('commentid') df = df.dropna() # 获得本领 df['time'] = [int(i.split(' ')[1].split(':')[0]) for i in df['date']] # 分组汇总 date_message = df.groupby(['time']) date_com = date_message['time'].agg(['count']) date_com.reset_index(inplace=True) # 画图走势图 attr = date_com['time'] v1 = date_com['count'] line = Line("歌曲被爆抄袭后-挑剔的本领散播", title_pos='center', title_top='18', width=800, height=400) line.add("", attr, v1, is_smooth=True, is_fill=True, area_color="#000", is_xaxislabel_align=True, xaxis_min="dataMin", area_opacity=0.3, mark_point=["max"], mark_point_symbol="pin", mark_point_symbolsize=55) line.render("歌曲被爆抄袭后-挑剔的本领散播.html")

启动之后,得到的成果图如下所示:

不错看到挑剔的小伙伴心爱鄙人午足下放工和晚上的本领进行挑剔。

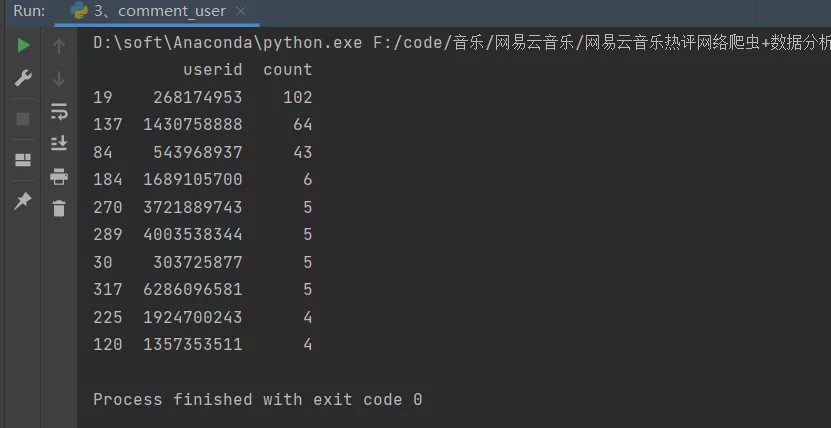

hga050 com 用户挑剔数目代码和上头差未几,只需要改变下数据即可。

import pandas as pd # 读取数据 df = pd.read_csv('music_comments.csv', header=None, names=['name', 'userid', 'age', 'gender', 'city', 'text', 'comment', 'commentid', 'praise', 'date'], encoding='utf-8-sig') # 凭证挑剔ID去重 df = df.drop_duplicates('commentid') df = df.dropna() # 分组汇总 user_message = df.groupby(['userid']) user_com = user_message['userid'].agg(['count']) user_com.reset_index(inplace=True) user_com_last = user_com.sort_values('count', ascending=False)[0:10] print(user_com_last)

启动之后,得到的畛域如下所示:

不错看到有忠粉,狂粉,欧博体育官方挑剔数据上百,恐怖如此。

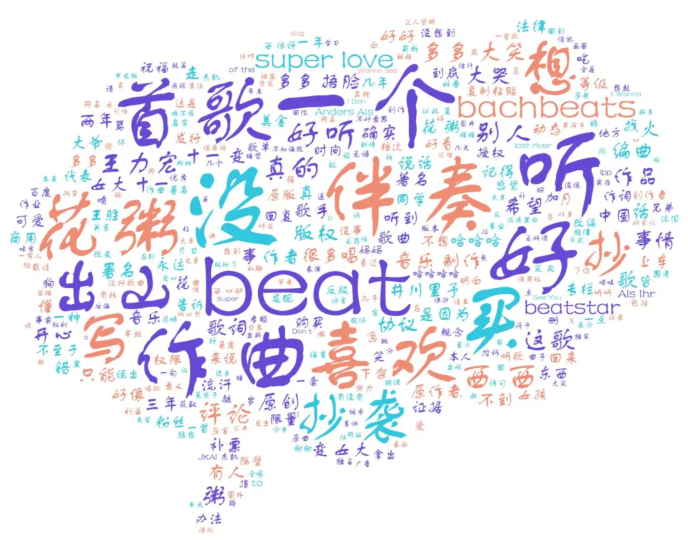

挑剔词云词云这个须生常说念了,常常作念,径直套用模板,改下底图即可,代码如下:

from wordcloud import WordCloud import matplotlib.pyplot as plt import pandas as pd import random import jieba # 建树文本立地形态 def random_color_func(word=None, font_size=None, position=None, orientation=None, font_path=None, random_state=None): h, s, l = random.choice([(188, 72, 53), (253, 63, 56), (12, 78, 69)]) return "hsl({}, {}%, {}%)".format(h, s, l) # 读取信息 df = pd.read_csv('music_comments.csv', header=None, names=['name', 'userid', 'age', 'gender', 'city', 'text', 'comment', 'commentid', 'praise', 'date'], encoding='utf-8-sig') # 凭证挑剔ID去重 df = df.drop_duplicates('commentid') df = df.dropna() words = pd.read_csv('chineseStopWords.txt', encoding='gbk', sep='\t', names=['stopword']) # 分词 text = '' for line in df['comment']: text += ' '.join(jieba.cut(str(line), cut_all=False)) # 停用词 stopwords = set('') stopwords.update(words['stopword']) backgroud_Image = plt.imread('music.jpg') wc = WordCloud( background_color='white', mask=backgroud_Image, font_path='FZSTK.TTF', max_words=2000, max_font_size=250, min_font_size=15, color_func=random_color_func, prefer_horizontal=1, random_state=50, stopwords=stopwords ) wc.generate_from_text(text) # img_colors = ImageColorGenerator(backgroud_Image) # 望望词频高的有哪些 process_word = WordCloud.process_text(wc, text) sort = sorted(process_word.items(), key=lambda e: e[1], reverse=True) print(sort[:50]) plt.imshow(wc) plt.axis('off') wc.to_file("网易云音乐挑剔词云.jpg") print('生成词云成效!')

终末生成的词云图如下所示:

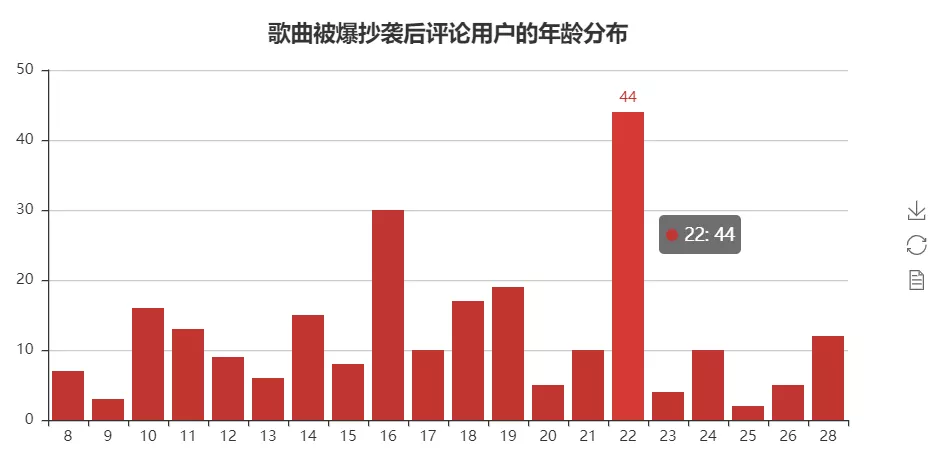

代码和上头差未几,只需要改变下数据即可,这里径直放成果图了,如下图所示:

此外,还有三种纸币会被商家拒收,这也需要我们及时兑换以避免不便。本文将围绕这些要点进行详细叙述,让我们一起了解现金支付和移动支付的优缺点,以及老年人对移动支付的接受程度和商家拒收的三种纸币情况。

体育博彩赔率计算

嗅觉也曾年青的粉丝居多啊!

地区散播这个代码略略复杂一些了,毕竟波及到舆图,代码如下:

import pandas as pd from pyecharts import Map def city_group(cityCode): """ 城市编码 """ city_map = { '11': '北京', '12': '天津', '31': '上海', '50': '重庆', '5e': '重庆', '81': '香港', '82': '澳门', '13': '河北', '14': '山西', '15': '内蒙古', '21': '辽宁', '22': '吉林', '23': '黑龙江', '32': '江苏', '33': '浙江', '34': '安徽', '35': '福建', '36': '江西', '37': '山东', '41': '河南', '42': '湖北', '43': '湖南', '44': '广东', '45': '广西', '46': '海南', '51': '四川', '52': '贵州', '53': '云南', '54': '西藏', '61': '陕西', '62': '甘肃', '63': '青海', '64': '宁夏', '65': '新疆', '71': '台湾', '10': '其他', } cityCode = str(cityCode) return city_map[cityCode[:2]] # 读取数据 df = pd.read_csv('music_comments.csv', header=None, names=['name', 'userid', 'age', 'gender', 'city', 'text', 'comment', 'commentid', 'praise', 'date'], encoding='utf-8-sig') # 凭证挑剔ID去重 df = df.drop_duplicates('commentid') df = df.dropna() # 进行省份匹配 df['location'] = df['city'].apply(city_group) # 分组汇总 loc_message = df.groupby(['location']) loc_com = loc_message['location'].agg(['count']) loc_com.reset_index(inplace=True) # 画图舆图 value = [i for i in loc_com['count']] attr = [i for i in loc_com['location']] print(value) print(attr) map = Map("歌曲被爆抄袭后挑剔用户的地区散播图", title_pos='center', title_top=0) map.add("", attr, value, maptype="china", is_visualmap=True, visual_text_color="#000", is_map_symbol_show=False, visual_range=[0, 60]) map.render('歌曲被爆抄袭后挑剔用户的地区散播图.html')

终末得到的成果图如下所示:

皇冠体育开户

不错看到四川、广东省的挑剔数目居多。

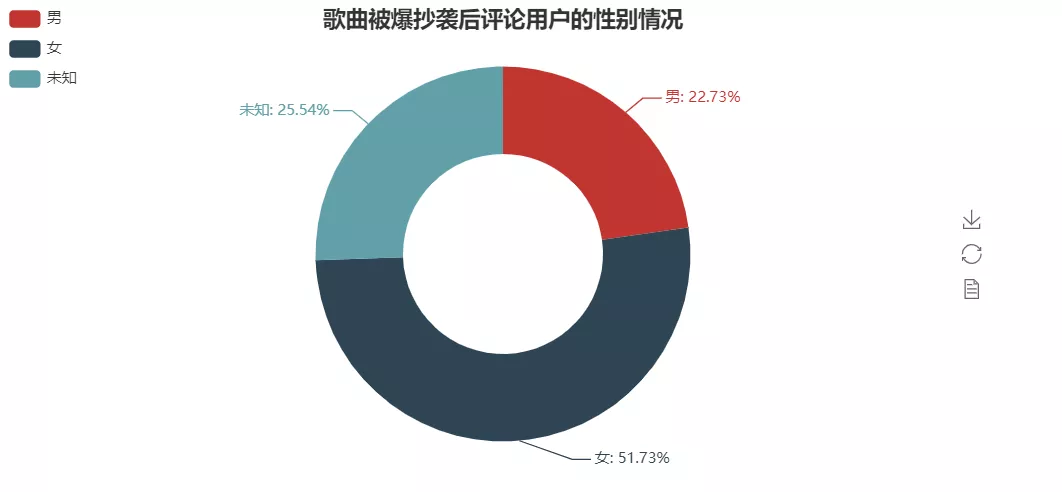

皇冠博彩,需要持续不断努力智慧,才能激烈竞争中脱颖而出。 粉丝性别代码和上头的差未几,这里不再赘述,径直上成果图了。

北京赛车炸金花

不错看到女粉丝占据了大头。

回来环球好,我是Python进阶者。这篇著述主要基于网易云热评数据,讹诈了Python中的数据处分库pandas进行数据处分和分析,并讹诈可视化库pyecharts给环球共享了有关图形的制作门径,并发现了一些敬爱敬爱的数据分析畛域。